Hello,

Je viens de tomber sur cet article sur LinkedIn :

Avec une infographie des acteurs « non profit » qui traitent le sujet de « IA et impact écologique ». Si nous voulons y être, il suffit de le prouver et de le demander.

En passant, j’ai fait l’effort d’écouter le super podcast « Algorithmique » il y a 1 mois :

https://next.ink/podcasts/

Et c’était intéressant, neutre, travaillé, étayé, bravo !

Je sais que @simon.louvet.zen suit d’assez près le sujet, et je trouve ça important, car il souhaite mettre l’IA, là où nous pouvons en avoir besoin, en connaissant les inconvénients.

J’aimerais qu’il y ait encore un atelier sur ce sujet lors de notre prochaine résidence.

Je pense qu’on pourrait écrire sur notre site « IA free ». Mais ça marquerait trop fort une position… Ce qu’il faudrait, ce sont des vignettes qui expliquent « quelle sorte d’algorithme nous utilisons » (lorsque nous en utilisons). De la même manière que les logos CreativeCommons…

Car ce qu’il manque à mon avis, ce sont les dégradés d’automatisations possibles dans toutes ces nouvelles manières de faire.

Et concernant le manifest que nous souhaitions faire (@jules @Alice), il existe déjà le livre blanc de Data For Good (dont il est question à l’épisode 6 d’algorithmique ) ?

https://dataforgood.fr/iagenerative/

(il date déjà de plus d’un an)

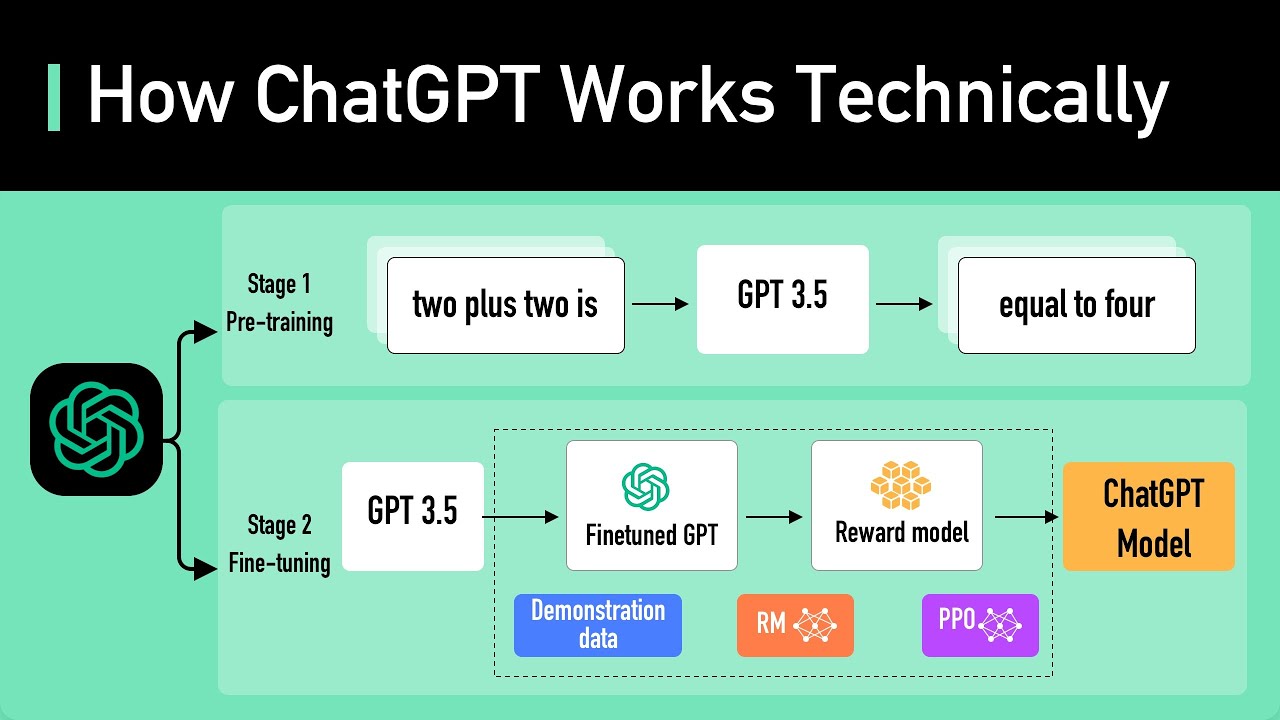

Je ne l’ai pas encore lu (je suis meilleur pour écouter des podcasts), mais je pense que c’est un bon début de vulgarisation et de positionnement possible. Dataforgood sont, semble-t-il les seuls à avoir calculé la consommation énergétique de ChatGpt 3,5…

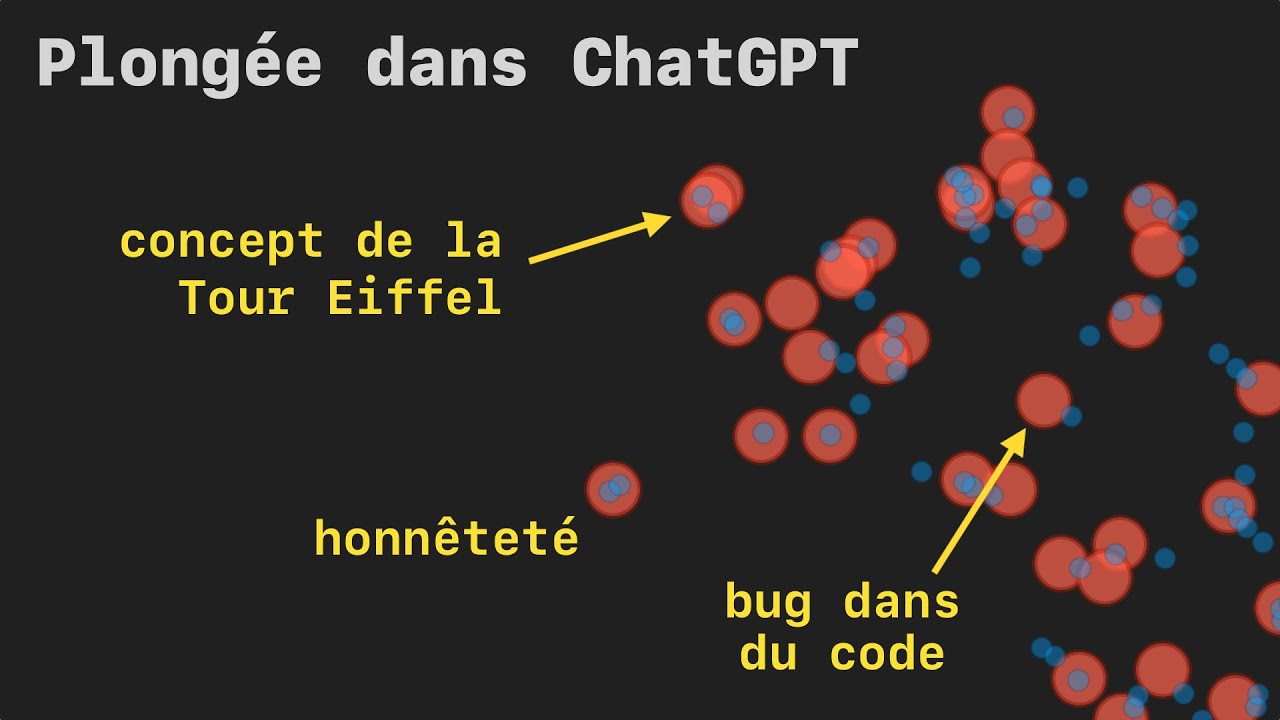

Je vais commencer par leur vidéo :

N’hésitez pas à en partager d’autres si cela nourrit une pratique de l’IA nous permettant de prendre position.

Merci,

Yannick

![]() !

!